Quand la technique trahit votre contenu

Vous publiez des articles de qualité, obtenez des backlinks et soignez votre maillage interne…

Pourtant, votre site reste invisible sur Google.

Avant de pointer du doigt votre contenu, regardez plutôt sous le capot :

Le problème vient souvent de votre SEO technique, c’est-à-dire de tout ce qui conditionne la manière dont les robots et les IA comprennent votre site.

Sans base technique solide, même le meilleur contenu ne sera jamais vu — ni par Googlebot, ni par ChatGPT, ni par Google AI Overviews.

Les erreurs techniques SEO : un frein majeur à la visibilité en ligne

Les erreurs techniques SEO figurent parmi les principaux obstacles à la visibilité d’un site web sur les moteurs de recherche, en particulier Google.

Elles regroupent divers dysfonctionnements : problèmes d’indexation, lenteur de chargement, mauvaise adaptation mobile, mauvaise configuration des balises ou encore liens internes et externes défectueux.

Bien que souvent imperceptibles pour l’utilisateur, ces erreurs compromettent le référencement, détériorent l’expérience de navigation et limitent le potentiel de trafic.

Comment les corriger pour optimiser le référencement

Pour remédier à ces dysfonctionnements, il est conseillé d’effectuer des audits techniques réguliers, d’optimiser la structure et la rapidité du site, de vérifier le balisage et de garantir la sécurité via le protocole HTTPS. Un suivi rigoureux des performances, associé à une gestion soignée des redirections et du contenu dupliqué, demeure essentiel pour préserver la qualité, la cohérence et la pertinence des pages web.

1. Erreurs liées à l’exploration (crawl)

Ces erreurs empêchent Googlebot d’accéder à votre contenu ou de parcourir votre site correctement.

Elles gaspillent votre budget de crawl et limitent votre visibilité dans les SERP.

Avant de produire du contenu, il faut d’abord assurer un accès optimal à l’information.

1.1 Contenu invisible à cause du JavaScript

Beaucoup de sites modernes utilisent des frameworks JS (React, Vue, Angular).

Mais ce rendu dynamique peut rendre votre contenu invisible pour Googlebot.

Résultat : vous publiez, mais Google ne voit rien.

⚠️Quel est le problème?

Le contenu généré côté client peut être invisible pour Google, même si tout semble parfait pour vos visiteurs.

Comment vérifier

- Google Search Console → Inspection d’URL → Afficher la page explorée (consultez cet article pour en savoir plus sur GSC)

- Si la capture est vide, Google ne “voit” pas votre contenu

🎯La solution :

- Utilisez le rendu côté serveur (SSR) ou la pré-génération statique (SSG)

- Testez vos pages avec Rendertron ou Prerender.io

1.2 Chaînes de redirections excessives

Chaque redirection est un virage pour les robots : une ou deux, ça passe. Cinq ou six, c’est un labyrinthe.

Et plus la route est longue, plus votre SEO s’affaiblit.

⚠️Les conséquences

- Dilution du link juice, c’est-à-dire une perte progressive de la valeur transmise entre les pages.

- Ralentissement du temps de chargement, dû aux redirections successives.

- Épuisement partiel du budget de crawl, les robots gaspillant leurs ressources sur des URLs intermédiaires.

🎯Ce qu’il faut faire

- Analysez l’ensemble de votre site avec un outil comme Screaming Frog pour repérer les redirections multiples.

- Identifiez et corrigez les redirections en chaîne ou en boucle, sources de perte de performance.

- Mettez à jour vos liens internes afin qu’ils pointent directement vers l’URL finale.

Une seule redirection, c’est acceptable. Cinq à la suite, c’est un frein SEO.

1.3 Pages fantômes qui gaspillent le budget de crawl

Des pages inutiles se glissent souvent dans votre site sans que vous le sachiez.

Elles consomment vos ressources d’exploration et brouillent la perception de Google.

Autrement dit : elles font du bruit, sans valeur ajoutée.

Les pages inutiles sont des pièges à crawl :

- Pages de test, d’archives ou de staging laissées accessibles aux robots.

- Pages issues de filtres de recherche internes sans réelle valeur SEO.

- URLs contenant des paramètres dynamiques générant des doublons inutiles.

- Pages temporaires (remerciement, validation de formulaire, etc.) indexées par erreur.

| Action | Résultat attendu |

|---|---|

| Bloquer via robots.txt | Empêche l’exploration inutile |

Ajouter noindex |

Exclut de l’indexation |

| Nettoyer le sitemap | Concentre le crawl sur vos pages clés |

1.4 Mauvaise gestion du fichier robots.txt

Le fichier robots.txt est votre panneau de signalisation pour Google.

Mal configuré, il peut bloquer des sections entières de votre site.

C’est une petite erreur, mais souvent fatale.

⚠️Les erreurs fréquentes

- Blocage accidentel de répertoires essentiels comme

/blog/ou/images/dans le fichier robots.txt. - Absence de directives spécifiques pour les robots d’intelligence artificielle (IA bots).

- Omission du sitemap XML dans le fichier robots.txt, empêchant les moteurs d’y accéder facilement.

🎯 Le bon exemple

User-agent: *

Disallow: /admin/

Allow: /

Sitemap: https://www.votresite.com/sitemap.xml2. Erreurs d’indexation et de contenu

Ces erreurs empêchent Google d’ajouter vos pages à son index ou de comprendre leur importance.

Elles nuisent à votre cohérence éditoriale et à votre positionnement sur les bons mots-clés.

Sans indexation claire, vos efforts éditoriaux sont tout simplement invisibles.

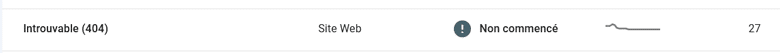

2.1 Erreurs 404 mal gérées

Les erreurs 404 (pages introuvables) font partie de la vie d’un site.

Mais mal gérées, elles signalent à Google un site négligé ou mal entretenu.

Trop de 404, et votre crédibilité technique s’effrite.

⚠️Les conséquences

- Une expérience utilisateur dégradée : l’internaute se perd ou quitte le site face à des erreurs ou redirections inutiles.

- Un gaspillage du budget de crawl, Google explorant des URLs inutiles au lieu de vos pages stratégiques.

- Un signal négatif envoyé à Google, pouvant impacter l’indexation et la visibilité de votre site.

🎯Les solutions

- Analysez le rapport “Couverture” dans Google Search Console pour identifier les erreurs 404 et pages introuvables.

- Mettez en place des redirections 301 vers des pages pertinentes pour conserver le trafic et le PageRank.

- Évitez de rediriger toutes les 404 vers la page d’accueil : orientez-les plutôt vers la page la plus cohérente thématiquement.

2.2 Cannibalisation de mots-clés

Quand deux pages ciblent la même requête, Google se perd et a du mal à choisir la plus pertinente.

Aucune des deux ne prend le dessus, et vous perdez en performance.

C’est une erreur très fréquente dans les blogs et dans les sites e-commerces.

Principe de base

Une intention de recherche = une seule page.

🎯 Pour corriger

- Fusionnez ou différenciez les contenus afin d’éliminer les doublons.

- Mettez en place des balises

rel=canonicalpour indiquer la version de référence à Google. - Surveillez régulièrement vos requêtes et vos pages dupliquées dans Google Search Console.

2.3 Contenu dupliqué (duplicate content)

Le contenu dupliqué brouille l’analyse sémantique de Google.

Le moteur ne sait plus quelle page privilégier, et finit souvent par en ignorer plusieurs.

C’est un tueur silencieux du SEO.

Origines fréquentes

- La coexistence des versions HTTP/HTTPS ou www/non-www, qui crée des doublons d’indexation.

- Des pages produits accessibles via plusieurs URLs (paramètres, filtres, trames dynamiques).

- La duplication de contenu entre fiches produits ou catégories similaires.

| Solution | Exemple |

|---|---|

| Balise canonical | <link rel="canonical" href="https://votresite.com/page-originale/"> |

| Redirections 301 | Fusionner les doublons |

| Consolidation du contenu | Supprimer les variantes inutiles |

2.4 Mauvaise gestion des balises meta

Les balises meta sont vos cartes d’identité SEO.

Mal renseignées, elles nuisent à la compréhension de vos pages.

Elles influencent directement le CTR et la clarté du message.

⚠️À surveiller

- Évitez l’absence de balise

<meta name="description">: elle influence le taux de clics dans les résultats de recherche. - Contrôlez la longueur et l’unicité de vos balises title : elles doivent être concises, pertinentes et distinctes pour chaque page.

- Utilisez les attributs

noindexetnofollowavec discernement afin de ne pas bloquer par erreur l’indexation de pages importantes.

Astuce : chaque page doit avoir un titre unique, descriptif et concis, idéalement ≤ 60 caractères.

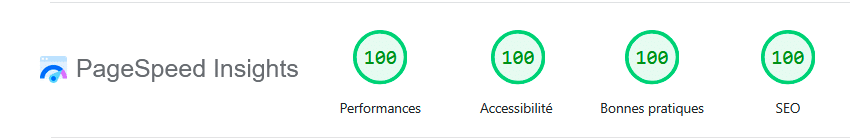

3. Erreurs de performance et d’expérience utilisateur

Ces erreurs ne se voient pas toujours à l’œil nu, mais elles impactent profondément le SEO.

Elles ralentissent votre site, augmentent le taux de rebond et pénalisent vos Core Web Vitals.

Google les considère désormais comme des facteurs de classement majeurs.

3.1 Temps de chargement trop long

Un site lent est un site invisible et Et Google, lui, préfère les sites rapides.

Chaque seconde supplémentaire de chargement fait chuter vos conversions.

| Facteur | Impact | Correctif |

|---|---|---|

| Images non compressées | Ralentissement majeur | Utiliser WebP et compression |

| Scripts lourds | Blocage du rendu | Charger en asynchrone |

| Hébergement lent | Mauvais LCP | Migrer vers un serveur performant |

Objectif : un Largest Contentful Paint (LCP) inférieur à 2,5 secondes.

Testez la performance de votre site en vous rendant sur Google Page Speed

3.2 Absence de HTTPS ou certificat expiré

Le HTTPS est un signal de confiance pour Google.

Un certificat expiré ou une mauvaise redirection HTTP/HTTPS peut vous coûter cher.

C’est un détail technique, mais capital.

Vérifier

- Vérifiez que votre certificat SSL est valide et à jour.

- Assurez-vous que toutes vos URLs redirigent correctement vers la version sécurisée (HTTPS).

- Contrôlez que votre sitemap et vos balises canoniques pointent bien vers des pages en HTTPS.

3.3 Mauvaise compatibilité mobile (Mobile-First Indexing)

Google indexe désormais la version mobile en premier.

Si votre site n’est pas optimisé, il sera déclassé, même sur desktop.

L’expérience mobile est devenue la priorité absolue.

Vérifications à faire :

- Vérifiez la compatibilité mobile de votre site avec le Test Mobile-Friendly de Google.

- Utilisez une police lisible, des boutons suffisamment espacés et des images adaptées aux écrans mobiles.

- Évitez les pop-ups intrusifs qui perturbent la navigation sur mobile

Astuce : concevez pour mobile d’abord, ajustez ensuite pour desktop.

4. Erreurs structurelles et d’architecture

Votre structure de site est la colonne vertébrale du référencement, une mauvaise hiérarchie ou un maillage interne mal pensé fragilisent toute votre stratégie.

C’est ici que se joue la compréhension globale de votre contenu par Google.

4.1 Architecture désorganisée

Un site mal structuré perd à la fois ses visiteurs et Google et sans hiérarchie claire, vos pages clés restent invisibles.

Une bonne architecture, c’est un SEO fluide et compréhensible.

🎯Bonnes pratiques

- Limitez la profondeur de navigation : un utilisateur ne devrait pas avoir besoin de plus de trois clics pour accéder à une page clé.

- Organisez vos contenus en silos thématiques cohérents afin de renforcer la pertinence sémantique.

- Respectez une hiérarchie logique : Accueil → Catégories → Sous-catégories → Pages.

- Maintenez un maillage interne équilibré pour faciliter la découverte des contenus.

4.2 Pagination et filtres mal configurés

L’infinite scroll est agréable pour l’utilisateur, mais une catastrophe pour Google.

Mal configurée, la pagination crée des centaines de doublons et votre site se transforme en labyrinthe de pages quasi identiques.

| Erreur | Conséquence | Solution |

|---|---|---|

| ?page=2 vs /page/2 | Contenu dupliqué | Uniformiser les URLs |

| Absence de rel= »next »/ »prev » | Perte de contexte | Ajouter ces balises |

| Filtres infinis | Crawl inutile | Bloquer via robots.txt |

À l’ère de l’IA : le SEO technique devient vital

Les IA génératives utilisent les mêmes signaux que Google pour évaluer la fiabilité d’un site et si votre base technique est mauvaise, elles ne vous citeront jamais.

Le SEO technique est donc devenu un critère d’autorité sémantique.

| Erreur technique | Conséquence IA |

|---|---|

| JavaScript bloquant | Contenu non lu |

| Redirections multiples | Perte de contexte |

| Structure confuse | Compréhension impossible |

| Contenu dupliqué | Source non fiable |

Optimiser pour les LLM (IA génératives)

Structure claire

- Utilisez des balises HTML sémantiques (H1, H2, H3) pour structurer vos contenus

- Mettez en forme vos informations avec des listes, des tableaux et des définitions pour faciliter la lecture

- Intégrez du balisage Schema.org (comme le type “FAQ”) afin d’enrichir vos résultats dans les moteurs de recherche

Contenu accessible

- Évitez le JavaScript dynamique qui complique l’indexation par Google

- Formulez des réponses précises et faciles à comprendre

- Expliquez clairement les notions clés pour guider vos lecteurs

Autorité

- Renforcez votre E-E-A-T en citant des sources vérifiables et reconnues.

- Optimisez vos Core Web Vitals et votre sécurité (HTTPS, mises à jour, pare-feu) pour un site performant.

- Développez un profil de liens entrants sain, basé sur la pertinence thématique et la fiabilité des domaines.

Conclusion : le SEO technique, fondation de votre visibilité

Le SEO moderne ne consiste plus à “plaire à Google”, mais à aider les robots et les IA à vous comprendre.

Vous pouvez avoir :

- le meilleur contenu, riche, précis et bien documenté ;

- une stratégie éditoriale parfaitement pensée ;

- une marque forte et cohérente dans son positionnement.

Mais sans une base technique saine, vous resterez invisible.

✅ Vos actions prioritaires

| Étape | Objectif |

|---|---|

| Audit technique (Screaming Frog, Search Console) | Détecter les erreurs |

| Vérifier le rendu d’URL | Assurer la visibilité du contenu |

| Nettoyer les pages inutiles | Libérer le budget de crawl |

| Réorganiser l’arborescence | Clarifier la navigation |

| Optimiser la vitesse et le mobile | Renforcer l’expérience utilisateur |

Aidez Google et les IA à vous comprendre. Votre trafic — et vos conversions — vous diront merci.